Die KI-Revolution hat Folgen, über die kaum jemand spricht

Wie neue Rechenzentren Energiepreise treiben und das Klima belasten

Wenn über Künstliche Intelligenz gesprochen wird, geht es meist um Produktivitätsschübe, neue Geschäftsmodelle und die Frage, ob Chatbots uns die Jobs wegnehmen. Deutlich seltener geht es um eine sehr irdische Seite des KI-Booms: Stromrechnungen, Netzausbau und Wasserknappheit. Doch genau dort entscheidet sich, ob KI ein Werkzeug der effizienten Transformation wird oder ein weiterer Treiber der Klimakrise.

Die neue Großindustrie im Hintergrund

Rechenzentren sind die Fabriken des Digitalzeitalters. Sie verbrennen keinen Kohlenstaub und stoßen keine weißen Dampfwolken aus Schornsteinen aus, sondern schlucken Strom und Wasser in Größenordnungen, die längst auf dem Niveau klassischer Industrieanlagen liegen.

Die Internationale Energieagentur (IEA) schätzt, dass Rechenzentren im Jahr 2024 weltweit rund 460 Terawattstunden Strom verbrauchen, also gut anderthalb Prozent der globalen Stromnachfrage. Unter dem aktuellen Wachstumspfad könnte sich dieser Bedarf bis 2030 mehr als verdoppeln und auf über 1.000 Terawattstunden steigen, bis 2035 sogar auf etwa 1.300 Terawattstunden.

Der wichtigste Treiber dieses Anstiegs ist laut IEA ausgerechnet der Teil der Branche, der für den Hype sorgt: KI-Anwendungen und Hochleistungsrechnen.

KI als Stromfresser im Rechenzentrum

Klassische Cloud-Dienste arbeiten seit Jahren an Effizienzgewinnen. Viele Alltagsanwendungen sind pro Dateneinheit inzwischen deutlich sparsamer geworden. Generative KI wie Sprachmodelle oder Bildgeneratoren funktioniert jedoch ganz anders. Moderne KI-Chips (GPUs) benötigen hohe Leistung pro Gerät, laufen dicht gepackt in Racks und müssen permanent gekühlt werden.

Einige Analysen gehen davon aus, dass KI-Workloads schon 2030 zwischen 35 und 50 Prozent des gesamten Stromverbrauchs von Rechenzentren ausmachen könnten, wenn der Trend ungebremst weitergeht.

Dabei geht es nicht nur um den laufenden Betrieb, sondern auch um das Training großer Modelle. Für das Training des Sprachmodells GPT-3 wurden beispielsweise rund 1.278 Megawattstunden Strom und etwa 550 Tonnen CO₂-Emissionen geschätzt, basierend auf dem durchschnittlichen Emissionsfaktor des US-Strommix. Das ist der jährliche Ausstoß von ungefähr 120 Mittelklassewagen.

Stromhunger in Europa und Deutschland

Europa erlebt derzeit einen historischen Ausbau von Rechenzentrumskapazitäten. Allein 2025 sollen laut einer Branchenanalyse rund 937 Megawatt zusätzliche Leistung ans Netz gehen, 43 Prozent mehr als im Vorjahr. Besonders stark wachsen die Knoten Frankfurt, London, Amsterdam, Paris und Dublin.

Die Europäische Kommission schätzt, dass Rechenzentren 2024 etwa 70 Terawattstunden Strom verbraucht haben, rund drei Prozent der europäischen Stromnachfrage. Bis 2030 könnte dieser Bedarf auf etwa 115 Terawattstunden steigen.

Deutschland steht besonders unter Druck. Nach Angaben der Bundesregierung und verschiedener Studien verbrauchen Rechenzentren und kleinere IT-Installationen hierzulande derzeit rund 20 Terawattstunden pro Jahr, was etwa vier Prozent des gesamten Stromverbrauchs entspricht. Bis 2025 wird ein Anstieg auf gut 21 Terawattstunden erwartet, mehr als alle Wasserkraftwerke des Landes zusammen erzeugen.

Die Bundesnetzagentur rechnet damit, dass der Anteil der Rechenzentren am deutschen Stromverbrauch bis Mitte der 2030er Jahre auf bis zu zehn Prozent steigen könnte, wenn der Ausbau in der aktuellen Geschwindigkeit weitergeht.

Wenn der KI-Boom die Netze an ihre Grenzen bringt

Was diese Zahlen im Alltag bedeuten, zeigt sich derzeit drastisch in einzelnen Regionen. In Texas etwa verzeichnet der Netzbetreiber ERCOT eine regelrechte Flut von Anschlussanfragen für Großverbraucher. Allein im Jahr 2025 summieren sich die beantragten Lasten auf über 230 Gigawatt, fast viermal so viel wie Ende 2024. Über 70 Prozent davon stammen von neuen Rechenzentren für KI-Anwendungen.

Auch in Deutschland warnen Analysten, dass Stromverfügbarkeit zum Engpassfaktor wird. Die jährliche Stromnachfrage der deutschen Rechenzentren liegt bereits fast 50 Prozent über dem Jahresverbrauch der Stadt Berlin. In Metropolen wie Frankfurt wird es immer schwieriger, gleichzeitig neue Rechenzentren, Wohnungsbau und Elektromobilität an die bestehenden Netze anzuschließen.

Für Netzbetreiber bedeutet das Milliardeninvestitionen in Leitungen, Umspannwerke und Kraftwerke. Diese Kosten landen mittelbar bei allen Stromkundinnen und Stromkunden auf der Rechnung, unabhängig davon, ob sie generative KI selbst nutzen oder nicht.

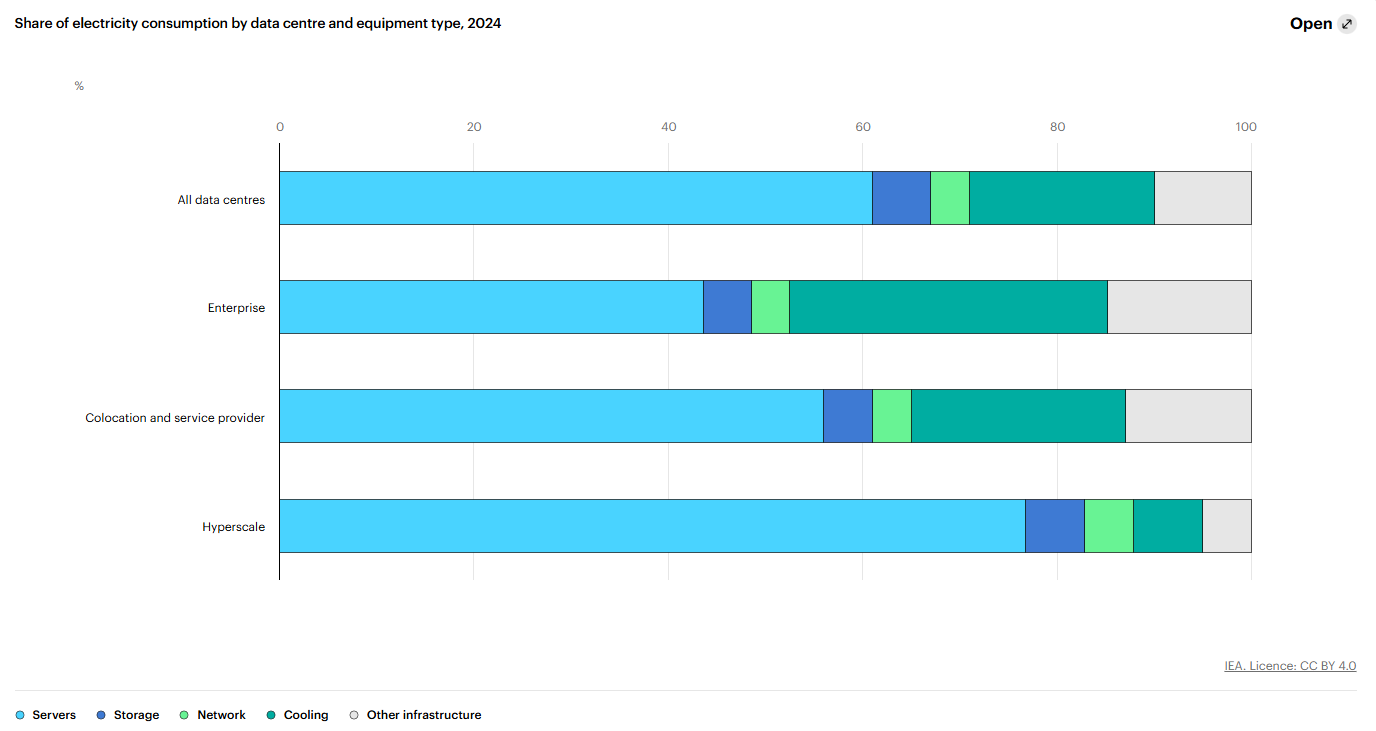

Speichersysteme (Storage) sind Geräte für die zentrale Datenspeicherung und -sicherung und machen etwa 5 Prozent des Stromverbrauchs aus.

Netzwerkgeräte (Network) umfassen Switches zum Verbinden von Geräten innerhalb des Rechenzentrums, Router zur Steuerung des Datenverkehrs und Load Balancer zur Leistungsoptimierung. Netzwerkgeräte verursachen bis zu 5 Prozent des Strombedarfs.

Kühlung und Umweltkontrolle (Cooling) beziehen sich auf Anlagen, die Temperatur und Luftfeuchtigkeit regulieren, damit die IT-Hardware unter optimalen Bedingungen betrieben werden kann. Der Anteil der Kühlsysteme am gesamten Energieverbrauch eines Rechenzentrums reicht von rund 7 Prozent bei effizienten Hyperscale-Rechenzentren bis zu über 30 Prozent bei weniger effizienten Enterprise-Rechenzentren.

Unterbrechungsfreie Stromversorgung (USV) sowie Notstromgeneratoren sorgen dafür, dass das Rechenzentrum auch bei Stromausfällen weiterläuft. Sowohl USV-Anlagen als auch Generatoren kommen selten zum Einsatz, sind aber notwendig, um die extrem hohen Anforderungen an die Betriebssicherheit eines Rechenzentrums zu erfüllen.

Weitere Infrastruktur (Other infrastructure), wie Beleuchtung oder Büroausstattung für das Personal vor Ort, gehört ebenfalls dazu.

Der Anteil dieser einzelnen Komponenten am Stromverbrauch eines Rechenzentrums variiert stark je nach Typ des Rechenzentrums und hängt von Art und Effizienz der jeweils eingesetzten Technik ab.

Grafik: IEA (2025), Energy and AI, IEA, Paris https://www.iea.org/reports/energy-and-ai, Licence: CC BY 4.0

Wasserverbrauch: KI im Konflikt mit trockenen Regionen

Neben Strom ist Wasser der zweite kritische Rohstoff der KI-Revolution. Viele Rechenzentren nutzen Verdunstungskühlung. Das spart zwar Energie, verschlingt aber enorme Mengen Wasser.

Die US-Umweltorganisation EESI beziffert den Wasserverbrauch großer Rechenzentren auf bis zu fünf Millionen Gallonen pro Tag. Das entspricht dem täglichen Wasserverbrauch einer Kleinstadt mit 10.000 bis 50.000 Einwohnerinnen und Einwohnern.

Eine aktuelle Untersuchung berichtet, dass Google im Jahr 2023 über alle Rechenzentren hinweg mehr als fünf Milliarden Gallonen Wasser verbrauchte, ein erheblicher Teil davon in ohnehin wassergestressten Regionen. Rund 31 Prozent der Süßwasserentnahmen stammen aus Gebieten mit mittlerer oder hoher Wasserknappheit. Parallel dazu bauen Amazon, Microsoft und Google weitere wasserintensive Anlagen ausgerechnet in einigen der trockensten Regionen der Welt.

Für Anwohnerinnen und Anwohner kann das sehr konkret werden, wenn kurzfristig neue Wasserwerke gebaut oder Preise angehoben werden müssen, weil ein nahe gelegenes Rechenzentrum Kühlwasser benötigt, das zuvor für Land- oder Trinkwassernutzung vorgesehen war.

Klimabilanz: Vom Trainingslauf bis zur Daueranfrage

Der ökologische Fußabdruck von KI setzt sich grob aus drei Teilen zusammen:

Training großer Modelle, das über Wochen oder Monate auf Tausenden Spezialchips läuft

Inference, also jede einzelne Anfrage von Nutzerinnen und Nutzern

Infrastruktur, vom Bau des Rechenzentrums bis zur Fertigung der Hardware

Beim Training fallen einmalig sehr hohe Emissionen an, wie das Beispiel GPT-3 zeigt. Beim täglichen Betrieb summiert sich hingegen die schiere Masse an Anfragen. Milliarden von Prompts pro Tag bedeuten Milliarden zusätzlicher Rechenoperationen, die fortlaufend Strom verbrauchen.

Interessant ist ein Blick auf die Pro-Einheit-Bilanz. Eine aktuelle Studie kommt zu dem Ergebnis, dass KI-Systeme pro Seite Text oder Bild, verglichen mit menschlicher Produktion, zum Teil deutlich weniger CO₂ emittieren, weil sie zwar energieintensiv, aber extrem schnell und skalierbar sind. Das ändert jedoch nichts an der Gesamtbilanz, wenn das Volumen der erzeugten Inhalte massiv steigt. Die berühmte Rebound-Falle: Was effizienter wird, wird oft auch viel öfter genutzt.

Steigende Energiekosten: Wer bezahlt den KI-Hunger

Steigende Stromnachfrage schlägt sich in mehreren Kostenblöcken nieder:

Beschaffungskosten: In vielen Märkten steigen die Großhandelspreise, wenn zusätzliche Großverbraucher auftreten oder Knappheiten entstehen. Die US-Energiebehörde EIA erwartet für 2024 bis 2026 neue Rekordwerte beim Stromverbrauch, unter anderem wegen Rechenzentren für KI und Kryptowährungen.

Netzentgelte: Der enorme Leistungsbedarf neuer Rechenzentren erfordert zusätzliche Leitungen und Umspannwerke. Die Investitionskosten werden über Netzentgelte auf alle verteilt.

Kapazitätssicherung: In Regionen mit schwankender Erzeugung müssen zusätzliche flexible Kraftwerke oder Speicher bereitstehen, um Lastspitzen abzufangen.

Besonders brisant ist das, wenn Rechenzentren in Regionen mit ohnehin hohen Strompreisen entstehen oder wenn sie zeitgleich mit Haushalten und Industrie hohe Lasten nachfragen, etwa an kalten Winterabenden.

Regulierung: Die EU zieht die Schrauben nur langsam an

Politisch rückt das Thema erst seit Kurzem in den Vordergrund. Die EU hat mit der überarbeiteten Energieeffizienzrichtlinie einen Rahmen geschaffen, der Rechenzentren in die Pflicht nimmt. Betreiber größerer Anlagen müssen seit 2024 detaillierte Kennzahlen zu Energieeffizienz und Nachhaltigkeit in eine europäische Datenbank melden.

Auf Basis dieser Daten entsteht ein EU-weiter Nachhaltigkeitsindex, eine Art Effizienzlabel für Rechenzentren. Ziel der Kommission ist, bis 2030 weitgehend klimaneutrale Rechenzentren zu erreichen und dafür ein eigenes „Data Centre Energy Efficiency Package“ auf den Weg zu bringen.

Gleichzeitig läuft allerdings eine gegenläufige Entwicklung: Unter dem Druck von Industrie und einigen Mitgliedstaaten werden Teile der europäischen Berichtspflichten wieder aufgeweicht, auch bei Umwelt- und Klimadaten. Die Frage, ob die Regulierung mit dem rasanten KI-Ausbau Schritt halten kann, ist damit offen.

Lösungsansätze: Wie KI grüner werden kann

Der KI-Boom muss nicht zwangsläufig ein Klimakiller sein. Mehrere Hebel werden derzeit diskutiert und zum Teil umgesetzt:

Sauberer Strom

Viele Hyperscaler schließen langfristige Lieferverträge für erneuerbaren Strom. Doch diese sogenannten Power Purchase Agreements müssen zusätzliches Grünstromangebot schaffen, statt nur bestehende Mengen umzubuchen. Entscheidend ist außerdem, dass die Stromproduktion zeitlich zu den Lasten passt.Abwärmenutzung

Rechenzentren produzieren große Mengen Wärme auf konstantem Temperaturniveau. In Dänemark oder den Niederlanden wird diese Abwärme bereits in Fernwärmenetze eingespeist. Auch in Deutschland sehen Studien hier ein erhebliches Potenzial. Voraussetzung sind jedoch flexible Netze und Investitionen auf kommunaler Ebene.Effizientere Hardware und Modelle

Neuere Chips sind pro Rechenoperation effizienter. Parallel dazu arbeiten KI-Forschende an sparsamen Modellarchitekturen, die weniger Parameter benötigen oder Teile der Berechnung auf Nutzergeräte verlagern.Standortwahl und Wasserstrategie

Rechenzentren sollten nicht in Regionen mit hoher Wasserknappheit errichtet werden oder dort nur luftbasierte Kühlung einsetzen. Saisonale Speicherkonzepte, Meerwasserentsalzung und Kreislaufführung von Wasser sind weitere Stellschrauben, aber alle mit eigener Umweltbilanz.Nutzungsdisziplin

Auf der Nachfrageseite bleibt eine unbequeme Frage: Muss jedes Meetingprotokoll von drei KI-Diensten parallel zusammengefasst werden. Müssen wir für jede Kleinigkeit hochauflösende Bilder generieren. Der ressourcenschonendste Computerschritt ist der, der gar nicht erst ausgeführt wird.

Fazit: Der Preis der Bequemlichkeit

Künstliche Intelligenz verspricht Produktivitätsgewinne, neue Dienstleistungen und effizientere Prozesse, auch im Klimaschutz. Doch der digitale Fortschritt kommt nicht zum Nulltarif. Hinter jeder Chat-Session stehen Rechenzentren, die mit realem Strom und realem Wasser arbeiten und reale Emissionen verursachen.

Die entscheidende Frage der nächsten Jahre lautet daher nicht mehr, ob wir KI nutzen, sondern unter welchen Bedingungen. Wenn politische Leitplanken, Infrastrukturplanung und eine bewusste Nutzung zusammenkommen, kann der KI-Boom mit der Energiewende versöhnt werden. Bleibt die Entwicklung dagegen ungebremst, droht ausgerechnet die Technologie, die viele als Lösung sehen, selbst zu einem Teil des Problems zu werden.

Weiterführende Quellen und Empfehlungen:

International Energy Agency (IEA)

Analysen zum weltweiten Stromverbrauch von Rechenzentren und KI

https://www.iea.org/topics/artificial-intelligence#meeting-electricity-demand

European Commission – Data Centres & Energy Efficiency

Infos zu EU-Richtlinien, Nachhaltigkeitsindex und neuen Vorgaben

https://commission.europa.eu

Uptime Institute – Data Center Energy Reports

Jährliche Reports zu Energiebedarf, Effizienz und globalen Trends

https://uptimeinstitute.com

Lawrence Berkeley National Laboratory (LBL)

Studien über Rechenzentren, Effizienz und CO₂-Einsparungen

https://eta.lbl.gov

Electric Power Research Institute (EPRI)

Forschung zur Auswirkung von KI und Rechenzentren auf Stromnetze

https://www.epri.com

Environmental Science & Technology – Research on AI Water Use

Wissenschaftliche Publikationen zum Wasserverbrauch von KI-Systemen

https://pubs.acs.org

Google Environmental Report

Daten zum Energie- und Wasserverbrauch der Google-Rechenzentren

https://sustainability.google

Microsoft Sustainability Reports

Detaillierte Angaben zu Energie, Wasser und Emissionen

https://www.microsoft.com/en-us/sustainability

Amazon Web Services (AWS) – Sustainability Hub

Daten und Ziele rund um Ressourceneffizienz bei AWS

https://aws.amazon.com/sustainability